반응형

[Batch Normalization]

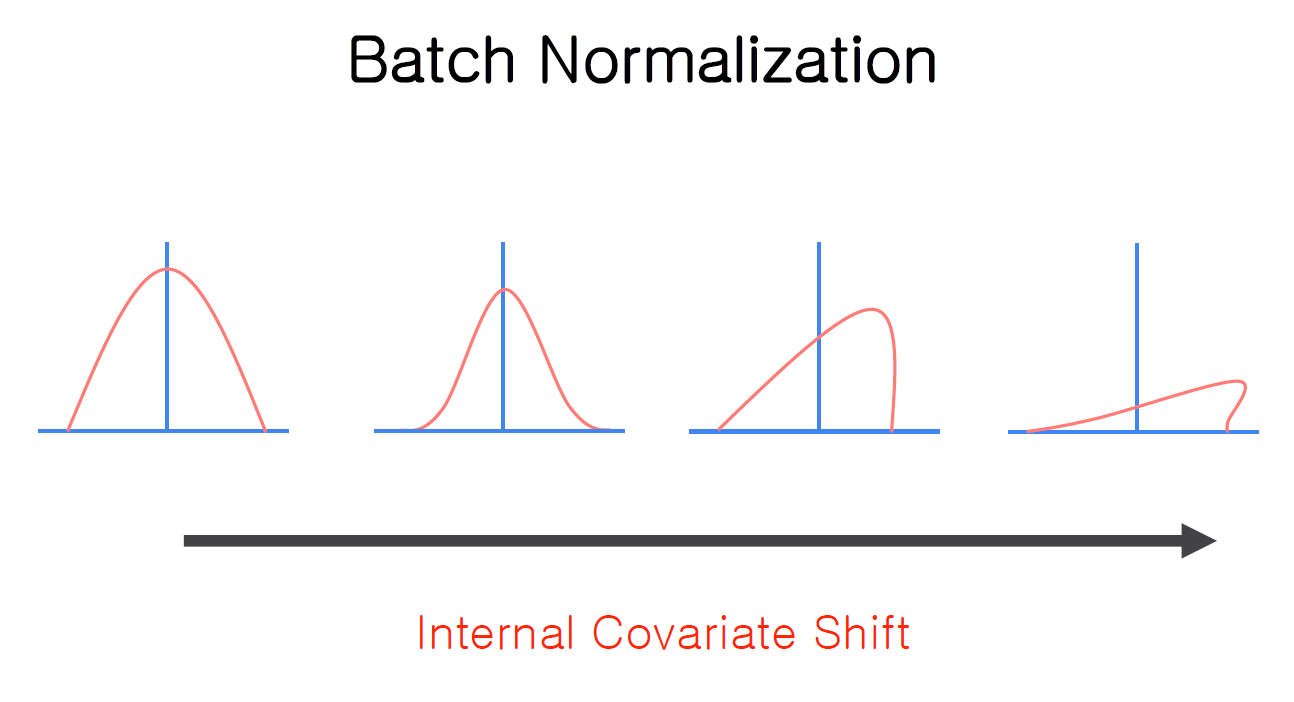

데이터의 distribution이 처음엔 적절히 분포되어 있었지만, 여러 layer들을 거치면서 점점 변형이 된다. 이런 현상을 Internal Covariate Shift라고 한다. 즉, Internal Covariate Shift를 막기 위해서 Batch Normalization이 필요하다.

Iayer에 input을 들어오는 데이터의 distribution을 계속 Normalization 시켜서 데이터의 distribution이 항상 일정하게 유지되도록 한다. x’ 값에 학습이 되는 파라미터를 적용한 다음에 Iayer의 새로운 input 값으로 추가한다.

[code] Create Network

이전에 Relu 함수에서 사용한 code와 거의 일치한다. Relu 함수에서 사용한 code와 다른 점은 network를 구성할 때 batch_norm() 함수도 추가하여 model을 구성한다는 것이다.

반응형

'인공지능 > 모두를 위한 딥러닝 시즌 2' 카테고리의 다른 글

| Dropout (0) | 2023.08.20 |

|---|---|

| Weight Initialization (0) | 2023.08.20 |

| Relu (0) | 2023.08.13 |

| XOR 문제 딥러닝으로 풀기 (0) | 2023.08.13 |

| 딥러닝의 기본 개념 (0) | 2023.08.13 |