반응형

Lec

[Predicting exam score]

One-variable: 한 개의 변수를 사용

Multi-variable: 다수의 변수를 사용

-> 늘어난 변수만큼 가중치를 필요로 한다.

[Matrix multiplication]

변수가 많을 때의 복잡한 수식을 간단하게 풀어낼 수 있다.

-> Dot Product 계산으로 A 행렬의 첫 번째 행과 B 행렬의 첫 번째 열을 곱하여 얻은 결과로 C 행렬을 구성한다.

-> H(X) = XW로 나타낼 수 있다. (X는 Matrix를 의미함)

[Hypothesis using matrix]

변수와 데이터가 많은 경우에도 상관없이 H(X) = XW로 간편하게 나타낼 수 있다.

Lab

[Hypothesis using matrix]

입력 값 x1, x2, x3를 이용하여 결과 값 y를 예측한다.

-> 변수가 3개이므로 가중치도 3개가 필요하다.

-> Gradient descent로 학습을 진행하기 위해 GradientTape()를 사용하여 구현한다.

-> 가중치의 값을 지속적으로 업데이트한다.

-> cost의 값이 급속하게 감소하다가 일정 정도 감소한 단계에서는 cost의 값이 크게 변하지 않는다.

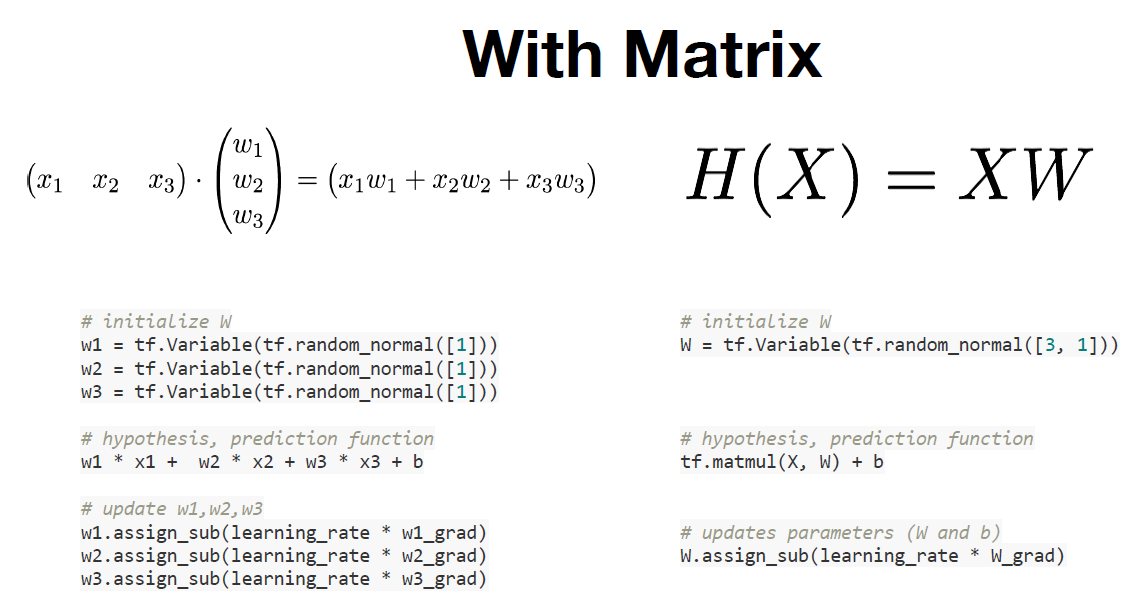

[With Matrix]

Matrix를 사용하면 더 간편하게 나타낼 수 있다.

반응형

'스터디 > 모두를 위한 딥러닝 시즌 2' 카테고리의 다른 글

| application and tips (0) | 2023.08.06 |

|---|---|

| Softmax Classifier (0) | 2023.08.06 |

| logistic_regression (0) | 2023.08.06 |

| Liner Regression and How to minimize cost (0) | 2023.07.30 |

| Simple Liner Regression (0) | 2023.07.30 |